チャットGPT、音声も聞き取る…韓国で英会話学習に急速に普及

このニュースをシェア

【03月08日 KOREA WAVE】米オープンAI社は2日(現地時間)、音声テキスト変換モデルの「ウィスパー」(Whisper)APIを公開した。人工知能(AI)が人の言葉を理解し、適切な答えを出せるようAIコールセンターが一歩近づいた形だ。

オープンAIが昨年9月に公開したウィスパーは、ウェブで収集した68万時間の多言語やマルチタスクデータで学習した自動音声認識(ASR)システムだ。様々な言語の音声を認識したり、これを英語に翻訳してくれる。当時オープンAIは「大規模なデータセットをベースにイントネーションや周辺の騒音に対する堅牢性(robustness)が向上した。データセットの3分の1は非英語データだ」と説明した。

ウィスパーAPIは毎分0.006ドルで、さまざまなファイル形式(m4a・mp3・mp4・mpeg・mpga・wav・webm)に適用できる。オープンAIは「昨年9月に公開されたウィスパーは開発者コミュニティから賛辞を受けたが実行しにくいモデルだった。今はAPIを通じてウィスパーlarge-v2モデルを使用できるようになった。最適化されたスタックで他のサービスに比べて速いサービスを保障する」と強調した。

ただ、米ITメディアの「テッククランチ(Tech Crunch)」は、ウィスパーがすべての言語に同じ性能を発揮できないとみている。テッククランチは「ウィスパーは次の単語を予測するのに限界があり、データが不足した言語の場合、エラー発生率が高い。アマゾン・アップル・グーグル・IBM・マイクロソフトの音声認識システムも、黒人より白人ユーザーに対するエラーははるかに少なかった」と指摘した。

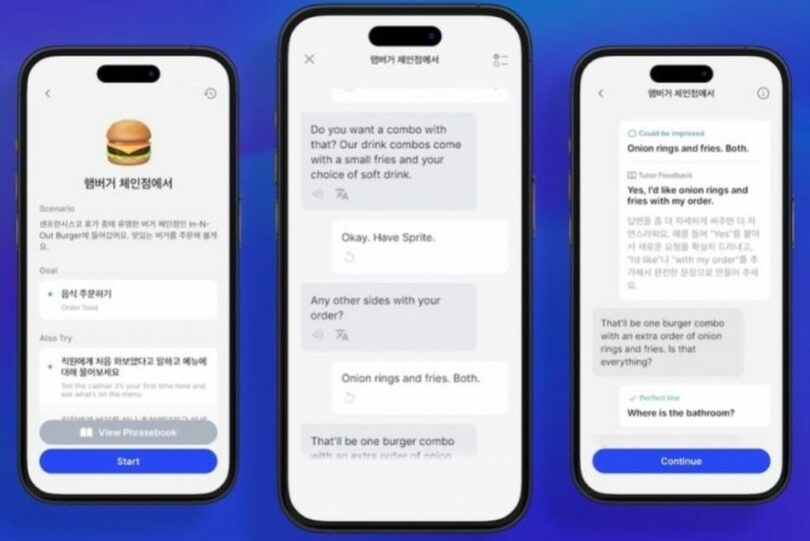

韓国ではウィスパーAPIを適用した英会話アプリ「Speak」が急速に普及している。例えば、ハンバーガー店で食べ物を注文する状況で英語で話せば、AIがこれを認識し、それに合った回答を出す。オープンAIは「ウィスパーはあらゆるレベルの言語学習者に人間レベルの精度を提供する。オープンな会話練習と正確なフィードバックを提供する」と説明している。

(c)MONEYTODAY/KOREA WAVE/AFPBB News